運用少量點雲之單攝影機深度估算

運用少量點雲之單攝影機深度估算

Mono-Camera Depth Estimation with Sparse Point Cloud

莊祐銓 章祐慈 陳永昇

國立交通大學 資訊工程系

國立交通大學 資訊工程系

一、研究背景

現今有眾多與深度估測相關之研究是基於單張RGB影像進行深度預測,但觀察其研究結果可發現,效果往往遠低基於雙目視覺(stereo)之方法。這是由於單目視覺系統缺乏了許多與深度有關的資訊,因此我們選用易取得之低解析深度感測器(參考圖一)來獲得並加入稀疏深度資訊,提升預測準確性。

圖一、低解析深度感測方法 : VLP-16(左)、SLAM(右)

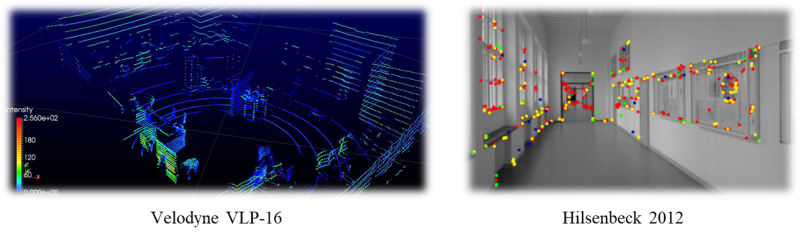

深度感測器種類繁多,例如光學雷達(LiDAR)、雙目相機和Kinect等等,但上述感測器都有其限制與問題:(1)高解析之LiDAR售價十分昂貴,(2)雙目相機架設過程繁瑣且校正不易,(3) Kinect有距離的限制並且對光很敏感[1]。有鑑於上述條件限制,本研究發展出基於單目相機與稀疏深度資訊之深度回歸網路模型來預測深度值。如下圖二,輸入為一張RGB影像和其對應的稀疏深度資訊,輸出則為完整解析度的深度圖。

圖二、網路輸入及輸出資訊[1]

二、深層神經網路架構

我們的深層神經網路架構分成三大部分(圖三),第一部分為編碼層(Encoding Layers),此處利用預訓練過的ResNet-50提取影像特徵,接著使用SE-SPP Module獲得多尺度特徵圖,提升整體網路能力,然後透過解碼層(Decoding Layers)的Up-Projection上採樣方法來還原影像大小,最終輸出原解析度的深度預測圖。

圖三、深度預測網路架構,輸入影像來自NYU-Depth-v2資料庫

三、加強網路提取特徵能力

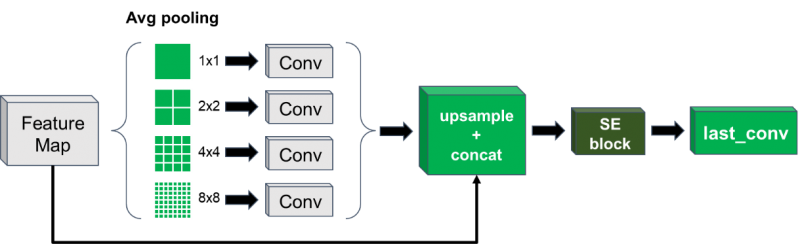

(1)SE-SPP Module

SE-SPP Module能夠使網路獲得多尺度特徵圖以及賦予網路篩選重要特徵的能力。此模型由兩個架構組成,分別為:Squeeze-and-Excitation Networks[4]和Spatial Pyramid Pooling[2][3],透過結合這兩種架構能夠有效加強重點特徵的代表性並且得到更好的深度預測結果。

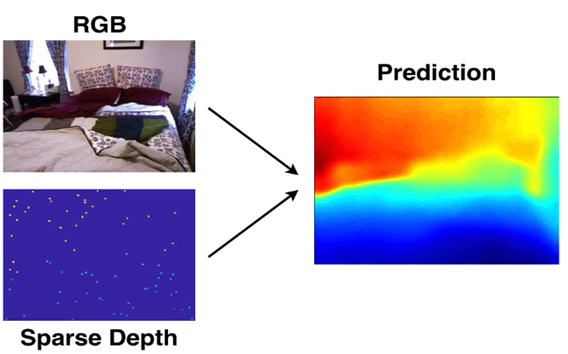

(2)Squeeze-and-Excitation Networks

SE Block並非完整的網路架構,主要是鑲嵌到其他模型中做為一個子結構。此架構可分為兩部分(圖四),第一部分為Squeeze Block,先將特徵作Average Pooling得到全局資訊再經過第二部分Excitation Block重新調整各特徵之間所佔據的權重比例。

(2)Squeeze-and-Excitation Networks

SE Block並非完整的網路架構,主要是鑲嵌到其他模型中做為一個子結構。此架構可分為兩部分(圖四),第一部分為Squeeze Block,先將特徵作Average Pooling得到全局資訊再經過第二部分Excitation Block重新調整各特徵之間所佔據的權重比例。

圖四、Squeeze-and-Excitation Networks架構

(3)Spatial Pyramid Pooling

SPP Block架構,如圖五所示,透過不同大小的Average Pooling得到多尺度感受視野(Receptive field)的特徵圖,藉此使網路學習物體和其子區域之間的關係,同時也提升網路對於物體形變有很好的魯棒性,使深度估測達到更好的結果。

圖五、Spatial Pyramid Pooling架構

四、結果與討論

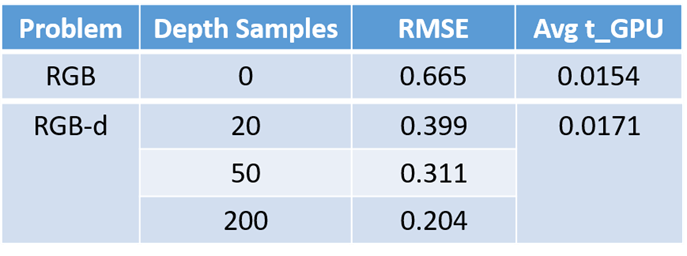

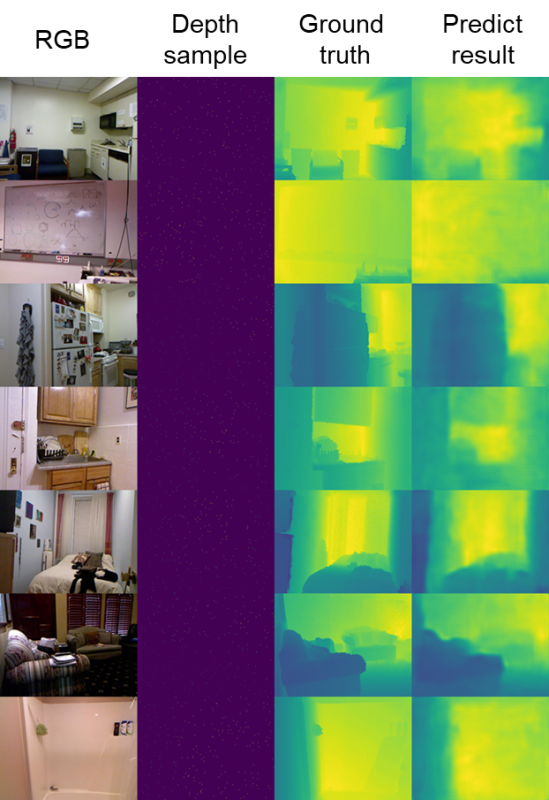

下表一為實驗結果,我們僅加入約20個點雲資訊,預測的準確度就提升了一倍之多,由此可見,稀疏的深度資訊有著極大的貢獻,不過隨著點雲數量的增加,造成運算量(Avg t_GPU)小幅上升,但預測誤差值(RMSE)大幅下降。下圖六為預測結果,可以發現我們預測出的深度圖對於大致上物體的輪廓以及形狀邊界都有很好的呈現。

- RMSE: Root Mean Squared Error

- Avg t_GPU: Average computationl time of GPU

表一、比較不同點雲數量對預測的影響

圖六、深度估算結果

參考文獻

[1] Fangchang Ma and Sertac Karaman, “Sparse-to-Dense: Depth Prediction from Sparse Depth Samples and a Single Image” ICRA 2018[2] Jia-Ren Chang and Yong-Sheng Chen, “Pyramid Stereo Matching Network” CVPR 2018

[3] Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun, “Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition” IEEE 2015

[4] Jie Hu, Li Shen and Gang Sun, “Squeeze-and-Excitation Networks” CVPR 2018